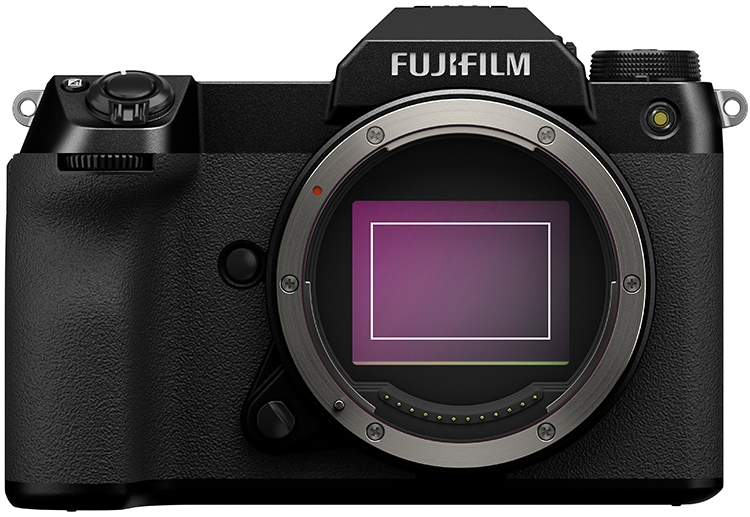

Wenn eine neue Mittelformatkamera vorgestellt wird, wie Ende Januar die Fujifilm GFX 100S, regt das Diskussionen darüber an, welche Vorteile größere Sensoren bringen. Schauen wir mal.

Immer wieder tauchen Gerüchte im Internet auf, dass Hersteller wie Canon, Nikon oder auch Olympus (OM Digital Solutions) an Mittelformatkameras denken. Bisher war nie etwas an diesen Gerüchten dran und dabei wird es wohl auch bleiben. Wer schon Mittelformatkameras im Programm hat ist z. B. Fujifilm, und da die GFX 50S und auch die GFX 100 schon in der Redaktion waren, werfen wir einen Blick auf diese Mittelformatkameras.

Mit der GFX 100S hat Fujifilm nun zwei spiegellose Mittelformatmodelle mit 102 MPix und zwei mit 51 MPix im Programm. Ihre Sensoren sind mit 43,8 x 32,9 mm und einer Diagonale von 55 mm rund 1,7x größer als Vollformatsensoren mit rund 36 x 24 mm.

Bezogen auf die Größe der Pixel (Pixel Pitch) bedeutet das, dass die Pixel der 51-MPix-Kameras mit 5,3µ größer sind, als die einer 53-MPix-Vollformatkamera (4,1 µ), und dass die Pixel der 102-MPix-Modelle bei fast doppelter Auflösung mit 3,8 µ nur wenig kleiner sind.

Die hohe Auflösung bedeutet mehr Details und feinere Details im Bild. Das spielt natürlich nur eine kleine Rolle, wenn man Bilder auf dem Monitor betrachtet. Mittelformatkameras werden aber für Profis entwickelt, deren Bilder groß gedruckt werden. Und da kann man sich dann auch mal nah vor ein Bild an der Wand stellen und sieht Details über Details im Motiv – aber keine Pixel.

Das ist aber nur ein Vorteil größerer Sensoren mit größeren Pixeln. Ein anderer ist der Dynamikumfang, der auch von der Größe der Pixel abhängig ist.

Der Dynamikumfang sagt aus, wie viele Helligkeitsstufen (angegeben in Blendenstufen oder EV) zwischen schwarzen und weißen Partien im Bild sichtbar werden können. Bei der Fujifilm GFX 100 / GFX 100S sind es 14 EV, bei der Fujifilm GFX 50 / GFX 50R sind es 12 EV!

Im Prinzip geht es darum. Wenn keine Photonen auf ein Pixel fallen, ist es egal, ob es groß oder klein ist. Wenn aber viel Licht auf den Sensor, also viele Photonen auf jedes Pixel fallen, dauert es bei großen Pixeln länger, bis sie „voll“ sind und Weiß ausgeben. Es stehen also mehr Tonwerte zwischen Schwarz und Weiß zur Verfügung.

In der Praxis bedeutet das, dass man gut „auf die Schatten“ belichten und längere Verschlusszeiten / größere Blenden erzielen kann, ohne dass die Lichter ausfressen.

Das bedeutet auch, dass seltener HDR-Aufnahmen nötig sind, um ein kontrastreiches Motiv mit durchgezeichneten Lichtern und Schatten ins Bild zu bekommen.

Auch die Farbwiedergabe profitiert von größeren Sensoren und größeren Pixeln.

Die GFX Kameras von Fujifilm machen RAW-Aufnahmen mit 16 Bit Farbtiefe pro RGB-Farbe möglich. Schon 14 Bit bedeutet, dass für eine Farbe 16.384 Helligkeitsstufen unterschieden werden können. Bei 16 Bit sind es 65.526 Helligkeitsstufen pro RGB-Farbe. Also können bei 16 Bit rund 281 Billionen Farbabstufungen erfasst werden. Entsprechend präzise ist die Wiedergabe von Farben und sanften Farbverläufen. Das spielt etwa in der Mode oder Porträtfotografie eine wichtige Rolle, und auch Landschaftsfotografen profitieren davon.

Großer Dynamikbereich und gigantische Farbtiefe sind auch von Vorteil, wenn bei der Entwicklung der RAW-Dateien Optimierungen vorgenommen werden müssen, denn der Spielraum dafür ist sehr groß.

Was bei der RAW-Entwicklung der Dateien aus einem der GFX-Modelle praktisch keine Rolle spielt, ist die Korrektur von Bildrauschen. Die großen Pixel und ihre Eigenschaft, Licht zu sammeln bringen es mit sich, dass die höheren Empfindlichkeiten in der Praxis problemlos genutzt werden können und auch Aufnahmen mit ISO 6400 sehr sauber sind.

Und noch einen Vorteil bringen die größeren Sensoren mit. Da für einen bestimmten Bildwinkel eine längere Brennweite benötigt wird als bei einem kleineren Sensor, kann man Aufnahmen mit einer schmaleren Schärfenzone und einem sanften Bokeh machen, ohne eine sehr hohe Lichtstärke zu benötigen. Der Crop-Faktor für die GFX-Modelle liegt bei 0,79x gegenüber Vollformat. Das 50-mm-Objektiv im Programm wirkt also wie ein 38-mm-Weitwinkel [@KB], aber mit schmalerer Schärfenzone!

Etwas anderes entzieht sich der Bewertung in Zahlen, nämlich der Einfluss des Mittelformats auf die Arbeitsweise.

Mit einer Mittelformatkamera geht man anders an eine Aufgabe heran. Schnappschüsse und Serienaufnahmen sind zwar möglich (die neue GFX 100S schafft fünf der großen Bilder pro Sekunde), aber nicht die Kernkompetenz dieser Kameras. Sie verführen vielmehr dazu, entschleunigt zu arbeiten, im Vorfeld zu überlegen, was man wie fotografieren möchte und das dann exakt umzusetzen.

Das heißt natürlich nicht, dass man auf die vielen Vorteile moderner Kameras verzichten müsste – ganz im Gegenteil, wie etwa ein Blick auf die top-aktuelle GFX 100S zeigt. Denn auch wenn die Sensorgröße in einer anderen Liga spielt, sind die aktuellen Mittelformatkamera eben … Kameras, die bieten was man zum Fotografieren braucht.

So kann etwa die Fujifilm GFX 100S, die nicht so groß ist wie manche Vollformat-DSLR, mit einem schnellen Autofokus aufwarten, der bis EV -5,5 arbeitet, ihr Stabilisator am Sensor (IBIS) kann bis zu 6 Verschlusszeitenstufen gegenüber der Freihandgrenze ausgleichen, es gibt Schmankerl wie die Filmsimulationen, mit denen man die Anmutung bestimmter Filme ins digitale Zeitalter holen kann, und das Gehäuse ist abgedichtet.

Mehr zur GFX 100S finden Sie hier.

Text (c) Herbert Kaspar

Produktbilder (c) Fujifilm

HIER NOCH EINIGE 100-MPIX-PRAXISBILDER

Da die neue Fujifilm GFX 100S noch nicht in der Redaktion war, um einen Praxistest zu durchlaufen, hier vier Beispiele, die mit der GFX 100 aufgenommen wurden, die ebenfalls über den 100-MPix-Mittelformatsensor verfügt.

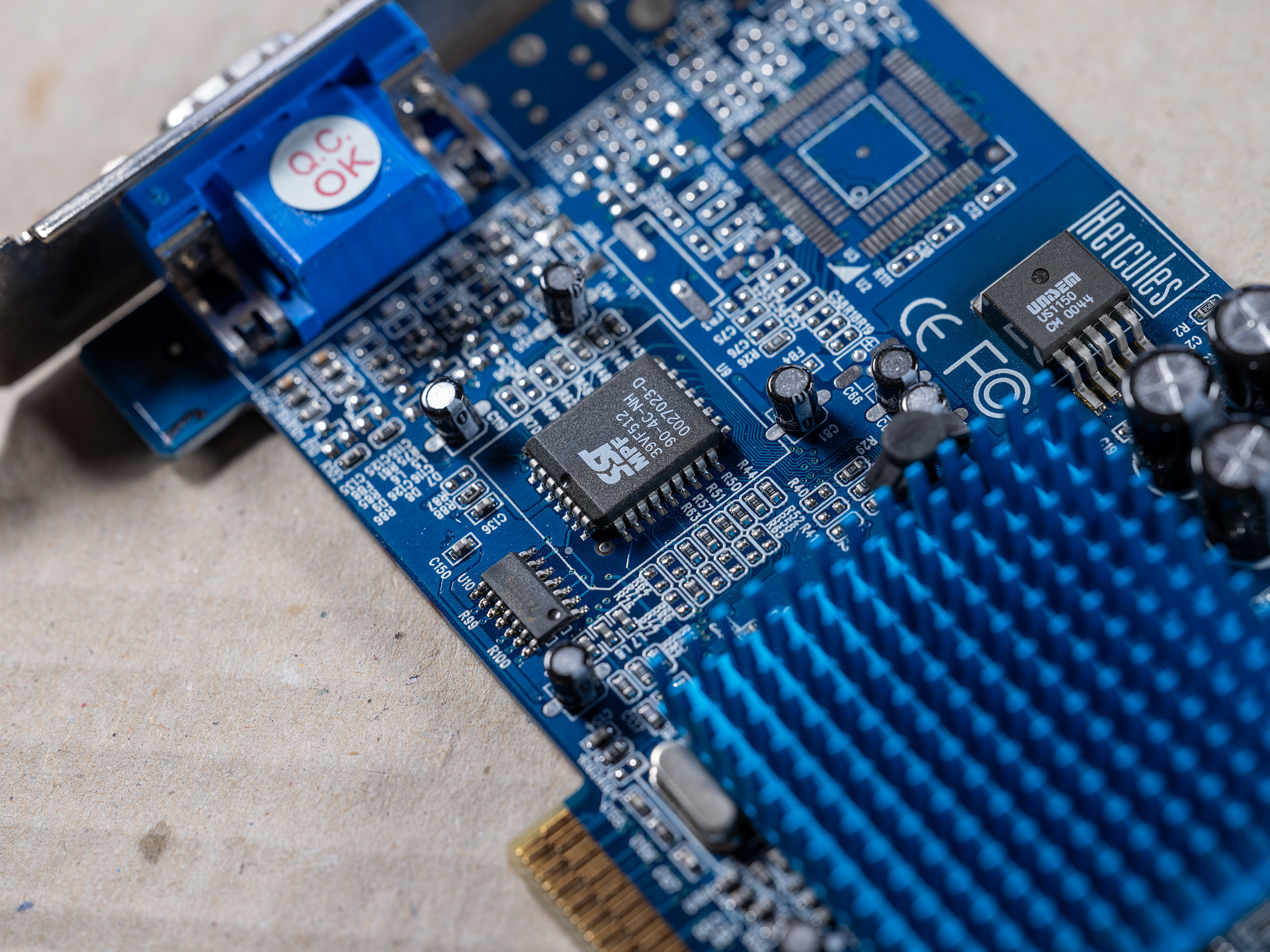

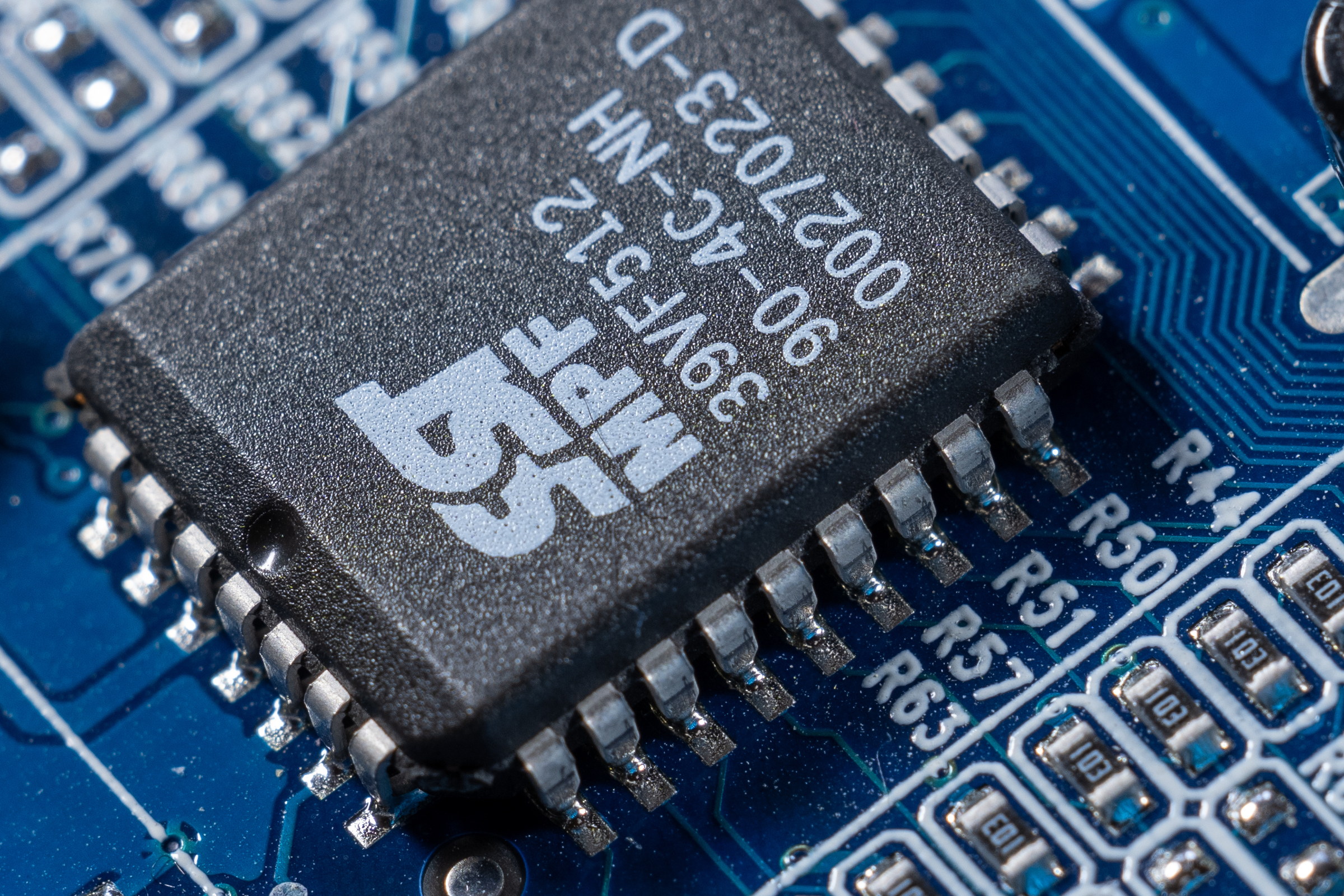

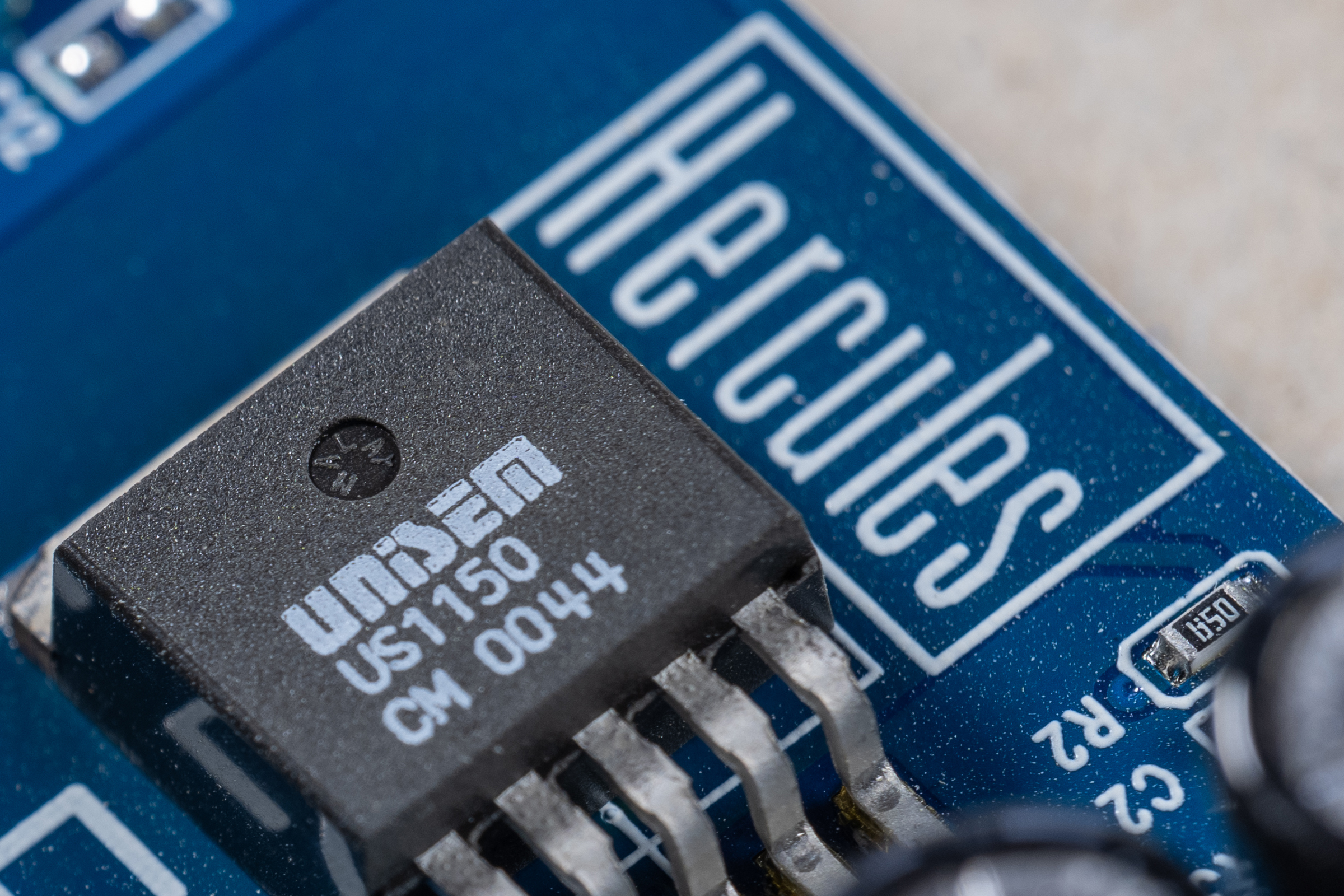

Zum Einsatz kamen das Standardobjektiv Fujifilm GF 63 mm F2,8 R WR (50 mm [@KB]) und das Makroobjektiv Fujifilm GF 120 mm F4 R LM OIS WR Macro (95 mm @KB].

Die Originalbilder sind 11648 x 8736 Pixel groß – das heißt, dass sie mit 300 ppi Druckauflösung, die wir für die d-pixx foto brauchen, mindestens 986 x 739 mm groß gedruckt werden können. Eine Doppelseite der d-pixx foto misst 420 x 297 mm!

Die Praxisbilder, die das ganze Motiv zeigen, wurden mit der aktuellen Version von Adobe auf eine Breite von 2400 Pixeln gebracht.

Dazu kommen jeweils zwei 100-%-Crops. Sie zeigen 2400 x 1600 Pixel aus dem 11648 x 8736 Pixel großen Originalbild.

Beachten Sie bitte, dass die Bildqualität, besonders die Farbwiedergabe, auch von den Einstellungen Ihres Monitors abhängt!

Fujifilm GFX 100 mit GF 63 mm F2,8 R WR

Die Fassade des Kellereischlosses in Hammelburg (Heimat der d-pixx foto) gehört zu den Standardmotiven der Praxistestaufnahmen. Die beiden 100-%-Crops zeigen jeden Knoten im Taubenschutznetz vor dem prächtigen Wappen und die Struktur in den Ziegeln.

Eigentlich sollte das Metall-Netz auf der Outdoor-Tischtennisplatte in der Mitte sein – das hat nicht ganz geklappt! Sorry. Die 100-%-Crops zeigen, wie die feinen Strukturen der Blätter ins Bild kommen -sofern sie in der Schärfenzone liegen, die für ein Standardobjektiv bei Blende 2,8 sehr schmal ausfällt. Sowohl die Blätter auf der Sonnen- wie auch auf der Schattenseite sind gut durchgezeichnet.

Fujifilm GFX 100 mit GF 120 mm F4 R LM OIS WR

Die Orchidee zeigt feine Nuancen im Weiß der Blätter, im Grün der Stängel und dazu Farbverläufe innerhalb der Blüten. Die beiden Crops zeigen, dass der große Sensor das hervorragend ins Bild bringt. Außerhalb der Schärfenzone kommen die Blätter mit einer samtigen Unschärfe ins Bild.

Auf die Hercules-Grafikkarte war ich vor langer Zeit stolz (wenn ich mich recht erinnere, war an Digitalkameras damals noch nicht zu denken …). Die beiden Crops zeigen die knackige Schärfe und das hohe Auflösungsvermögen in der Schärfenebene und den schön sanften Verlauf zwischen Schärfe und Unschärfe.

Allgemein kann ich aus mittlerweile eigener Erfahrung zum Thema Mittelformat nur sagen: es macht einfach Spaß!

Wobei meine "Dicke" ja auch "nur" 51MP hat und eher wie ein Backstein gebaut ist: so groß, schwer und langlebig…

Vielleicht ist sie so langlebig, weil sie so groß und schwer ist. Da überlegt man es sich, ob man sie mitnimmt oder nicht!

Ich nehme sie sogar sehr oft mit…sie liegt im Wald und im Garten auch oft mal auf dem Boden im Schmutz…zur Not kann ich sie ja unter dem Wasserhahn wieder sauber machen!

Weiß ja, dass du keinen Aufwand für ein gutes Bild scheust, aber ich wollte dich ein bisschen aufzwicken!

Weiß ich…aber wenn ich nicht entsprechend reagiere, macht es Dir ja auch keinen Spaß!

Das hast du ganz richtig erkannt!

Das kann ich mit meine Powershot S120 n icht machen…ich würde sie nicht mehr finden

Ich schlurf nur mit den Füßen über den Boden… wenn ich meine, ich hätte vor einen Steinm getreten und stolpere, habe ich sie gefunden…

[QUOTE=”FranckM, post: 20945, member: 46″]

Das kann ich mit meine Powershot S120 n icht machen…ich würde sie nicht mehr finden:ROFLMAO:

[/QUOTE]

Noch eine Gefahr: Nach den Anstrengungen beim Hintransport wird Thomas sicherlich seine Mittelformat nicht so schnell vergessen – aber eine Powershot wird sich beim Anmarsch dagegen wohl kaum im Gedächniss verankern…

Es droht daher bei der S120 noch die Gefahr des Vergessens…:):):)

Ja, aber als Belohnung hat man mir die Powershot einmalige High-ISO Performance ☺

Von Sony hört man ja nichts in Richtung MF … .

Ob Sensor-shift der "MF-Ersatz" ist? Damit muss ich mich noch befassen.

Ein Umstieg wäre natürlich ein kompletter Neuanfang, Body und Objektive. Das müsste sich wirklich richtig lohnen, bevor es mir sinnvoll erscheint.

Viele Grüße

Ralf

[QUOTE=”lichtjahr21, post: 20994, member: 15″]

Ob Sensor-shift der “MF-Ersatz” ist?

[/QUOTE]

Wohl nicht ganz.

Meine Oly hat einen solcehn Sensor-Shift. Dieser bringt die Cam von 20 auf 80 MP. (Bei Stativnutzung)

So weit mir bekannt, werden Details beim Sensor-Shift zwar besser definiert, aber Dinge, die wegen Ihrer Größe erst gar nicht bei der Aufnahme erfasst wurden, bleiben auch beim Sensor-Shift außen vor.

Das Bild wird im Ergebnis also deutlich größer, Details werden klarer und größer. Auch das Rauschen wird wohl verbessert.

Voraussetzung: Die Optik macht hier mit.

Eine “echte” 80 MP- Aufnahme ist aber detailreicher

Aber: Eine Optik -so überhaupt eine die 80MP Auflösung wirklich schaffen sollte, wird nicht aus der Portokasse bezahlbar sein.

Allerdings: Wenn ich eine solche High-End-Kombination (optisch und finanziell) habe, brauche ich mir bei der Aufnahme keine Gedanken über sich bewegende Dinge machen.

Beim Sensor-Shift können dagegen Effekte ähnlich wie bei Langzeitaufnahmen entstehen – auch wenn die Aufnahme (bei mir 8 Fotos in RAW)

schnell erstellt ist.

Allerdings braucht man auch hierbei ein gutes Objektiv, dass die 20MP auflöst.

Aber die gibt es schon für unter 1.000 Euro ( und weniger) im mFT-System ( und sind noch “tragbar”…:))

Beides sind schlussendlich Versuche, via Software ‚Substanz‘ zu generieren. Puristen werden sich mit Grausen abwenden … wie hieß es doch früher zu Autos und Leistung und Laufkultur: Hubraum, Hubraum und nochmals Hubraum

Auf der Docma-Homepage finden sich jedenfalls zwei interessante Artikel zur „Super Resolution

Es stimmt so nicht. Sensor-shift ist nicht bloss Software, sondern Hardware und Software. Der Sofftware verfügt über mehr Bildmaterial. Ich kenne Super resolution nicht, es wird wohl, wie digital Zoom, oder Sony’s Clear Image Zoom, immer eine Hochrechnung (Interpolation) um die Resolution zu erhöhen. War ist, dass heutige Verfahren rafiniert sind und deutlich bessere Ergebnisse produzieren als vor einige Jahre. Aber es werden immer noch NICHT EXISTIERENDE Bild-Informationen dazu addiert. Und das Prefix/Suffix ‘KI’ kannst du vergessen, es ist bloss Marketing, es handelt sich ganz einfach um rafinierte Algorithmen. Es ist schon mal ziemlich viel!

Ich war 40 Jahre in IT tätig, seit ca. 40 Jahre wird der KI-Durchbruch vorhergesagt, wir warten immer noch. KI Software sollte Lernfähig sein, also von eigene Fehler lernen, vor unbekannte Problem Lösung finden (wie ein Mensch) usw. Von all dem ist in unsere Bea-Software keine Spur.

Heute ist sogar Klo-Papier KI-fähig.

Glaub ich dir nicht! Wenn es so wäre, würde es sich vor Gebrauch verkrümeln …

Ja okay, die Hardware spielt hier auch mit: Grundsätzlich ist es doch so, dass hardwareseitig die Technik der Bildstabilisation genutzt wird und softwareseitig mehrere Aufnahmen gemacht werden mit jeweils leichtem Versatz des Sensors plus anschließendem Zusammenrechnen aller Bilddaten zu dann einem Bild.

Beim Sensor-Shifting wird – richtig ausgeführt – das Datenmaterial schon verbessert.

Umstritten (wenn dies das richtige Wort ist) ist z.B. bei meiner Cam jedoch die Freihandlösung beim Sensor-Shiften.

Das kann nach vorne, aber wohl auch nach hinten losgehen.

Vom Stativ aus ist das aber eine feine Sache.

Bei der reinen Softwarelösung werden die Daten dagegen ja nur mehr oder weniger intelligent “aufgeblasen”.

Allerdings sind die an der K1 mit der höheren Auflösung gemachten Fotos auch wieder sichtbar klarer und detailreicher als die "normalen" RAWs.

Es ist eine Verbesserung, aber ein Vergleich mit MF hinkt doch ein wenig…liegt vielleicht auch an den anderen Vorteilen von größeren Sensoren (auch wenn sie mehr Pixel haben – der "Pixelpitch" ist eben doch größer) – vor allem der Dynamikumfang und die LOW-ISO-Qualitäten sind da einfach besser. Noch!

Pentax und Sony nützen Pixel-Shift um die Farbinformation zu verbessern, es gibt keine Definition Erhöhung, die Bilder werden nicht grösser aber die Auflösung soll besser sein. Es sind (z.B. bei 300 DPI Ausdruck) keine grössere Ausdrücke möglich, aber die Qualität sollte steigen. Was mMn grössere Ausdrücke erlauben sollte – 240 DPI Ausdruck z.B.

Bei Oly und Pana wird die Definition erhöht, auf 40 & 80 MP bei Pana und zwischen 40 und 80 MP bei Oly, jenach Model.

Ich habe schon mit meine Oly M5 KII probiert, auf 40 MP und der Gewinn ist deutlich. Ich werde demnächst mit die G9 probieren, aber ich habe scho Teste in Web gelesen (und gesehen) mit beeindruckende Ergebnisse.

Bei Pentax werden die einzelnen Files in ein resultierendes RAW gepackt – wobei das aber nur durch die eigene Software ausgelsen werden kann.

Mit LR oder PS sieht man also keinen Vorteil…

Die Files werden deutlich größer (eben 4x so groß) und zeigen deutliche Detailverbesserungen.

Doch …definitiv werden Details klarer dargestellt…

[QUOTE=”Bratz, post: 21026, member: 6″]

Bei Pentax werden die einzelnen Files in ein resultierendes RAW gepackt – wobei das aber nur durch die eigene Software ausgelsen werden kann.

[/QUOTE]

Bei Oly werden die 8 benötigten Bilder für ein High-Res-Bild übrigens auch in ein resultierendes RAW (=.ORF) gebracht.

Auch wenn das Pixel-Shifting wohl relativ neu ist – das Thema “Superesolution” ist ja schon älter:

Das Wort “Superresolution” ist ja auch keine Erfindung von Adobe.

“Superresolution” konnte ja auch bisher dadurch erzeugt werden, dass man statt einer Weitwinkelaufnahme ein gleichwinkliges Panorama mit mehr Brennweite schießt und das Ganze halt montiert.

Eine weitere Möglichkeit ist eine freihändig schnell “durchgeschossene” größere Bildserie, die man dann stapelt und miteinander in einem Statistikmodus der Software verrechnet.

Das Pixel-Shifting ist dagegen wohl die Weiterentwicklung einer Methode, bei der man die Kamera auf ein Stativ anbrigt und das Ganze [U]leicht [/U]anstubst und ebenfalls eine größere Bildserie anfertigt.

Auch hier wird in der Software wieder gestapelt und verrechnet.

Man soll hierbei aber die Ausgangsbilder in der Größe verdoppeln bevor man verrechnet.

Die Verbesserung kann – so weit mir bekannt – bei den beiden letztgenannten Varianten einen Auflösungsgewinn von max. 1,5 erreichen, jedoch nicht den Faktor 2.

Bei Olympus und Panasonic wird der Sensor um 1/2 oder 1/4 Pixelbreite verschoben, um dort einen Bildpunkt aufzeichnen zu können, wo vorher kein Pixel war. Es werden mehr Bildpunkte aufgezeichnet – auf der mFT-Sensorfläche.

Bei Mittelformat sind die Pixel auf einer größeren Fläche untergebracht und können bei gleicher Auflösung größer sein, was der Dynamik und dem Rauschverhalten zugute kommt.